- 在 eclipse 中新建一个 Java Project

- 导入依赖:右键 Project 名称,打开 Properties 选项卡,打开“Java Build Path”,选择“Libraries”,“Add External JARs”,将文件

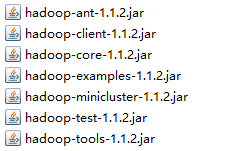

hadoop-1.1.2下 7 个 jar 包导入,如下图所示: - 关联 Hadoop 源码(可选,只是为了查看代码方便):右键 Project 名称,打开 Properties 选项卡,打开“Java Build Path”,选择“Project”,选择 Hadoop 源码项目

- 在项目的

\src下新建一个 Package,命名为“hdfs”

1 读文件

在hdfs下新建一个 class,命名为“App1”

App1.java:

1 | package hdfs; |

右键“Run As”,选择“Java Application”,可以成功运行,下面的控制台显示文件 hello 的内容

注意:这种方式只能读不能写,如果需要写,可以使用 HDFS 的 API(即 FileSystem 类)

2 FileSystem 类

可以直接调用 FileSystem 的子类完成 HDFS 操作

注:Eclipse 创建方法快捷键:Shift+Alt+M

Eclipse 创建局部变量快捷键:Shift+Alt+L

App2.java:

1 | package hdfs; |